L’intelligence artificielle traverse les siècles et les inventions, mais elle ne fait que commencer à révéler son potentiel créatif. Plus qu’un outil, l’IA est devenue le moteur inattendu de la créativité humaine. Retour sur une épopée où la science et l’imaginaire s’entrelacent depuis plus de deux millénaires.

Elle écrit, elle dessine, elle compose… L’intelligence artificielle semble aujourd’hui surgir de nulle part pour s’inviter dans notre quotidien. Et pourtant son histoire ne se résume pas à l’irruption récente de ChatGP. C’est une saga mêlant rêves anciens, percées scientifiques et phases d’enthousiasme suivies de désillusions. Derrière les prouesses spectaculaires des machines modernes se cache une longue aventure faite de mythes, d’utopies, d’échecs et de résurrections.

Automate verseur de vin (à gauche) : illustration du livre d'al-Jazari (à droite)

sur la connaissance des mécanismes ingénie (13ème siècle)

Des dieux aux ingénieurs : la préhistoire de l’IA

Bien avant les ordinateurs, l’idée de créer une intelligence non humaine habitait déjà les récits et les mythes.

Dans la Grèce antique, Héphaïstos, dieu forgeron, fabrique des serviteurs mécaniques pour aider les dieux.

Dans la tradition juive, le Golem, façonné dans l’argile et animé par un mot sacré, obéit aveuglément à son créateur.

Des automates anthropomorphes ont été construits par des artisans de toutes les civilisations, dont Yan Shi qui travaillait pour Ji Man, Héron d'Alexandrie, Al-Djazari, Wolfgang von Kampelen, etc..

Au XVIIIe siècle, les horlogers et inventeurs s’emparent de cette fascination : l’« écrivain » de Jacquet-Droz ou le fameux « Turc mécanique » – un automate joueur d’échecs, en réalité manipulé par un humain – donnent l’illusion qu’une machine peut penser. Illusion seulement, mais qui prépare les esprits à envisager qu’un jour, elle pourrait le faire vraiment.

À ce stade, tout n’est que mécanique et imagination, mais les bases conceptuelles sont posées : imiter le vivant par la technique.

Quand la machine commence à réfléchir

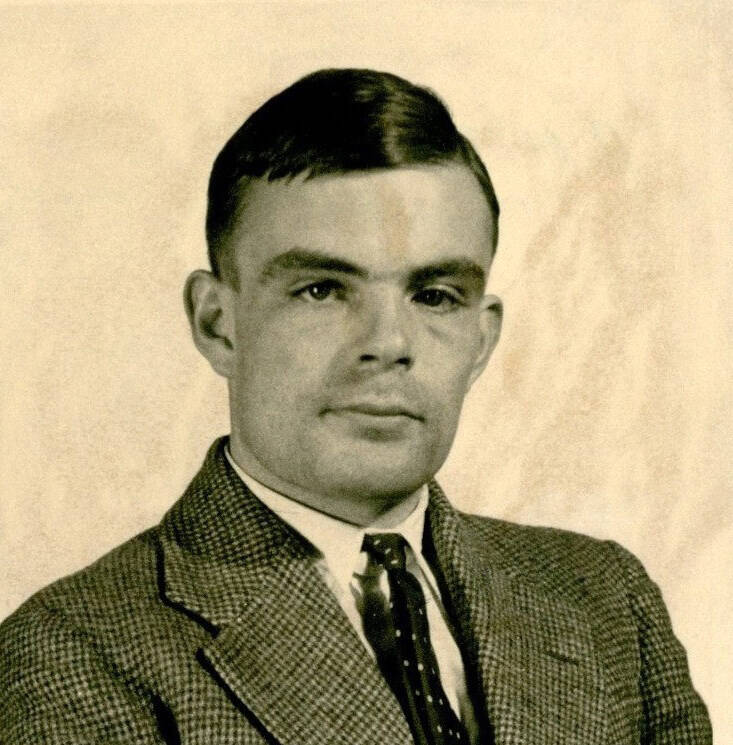

La Seconde Guerre mondiale et l’essor de l’informatique transforment la spéculation en projet concret. Alan Turing, mathématicien visionnaire, pose la question qui fera date : « Les machines peuvent-elles penser ? » En 1950, il propose un test, toujours célèbre, pour évaluer l’intelligence d’une machine : si, dans un dialogue écrit, on ne peut pas distinguer ses réponses de celles d’un humain, alors la machine « pense ».

En 1956, un petit groupe de chercheurs se réunit à Dartmouth (États-Unis). Ils inventent le terme Artificial Intelligence. L’histoire « officielle » de l’IA commence là.

Avec l’arrivée des premiers ordinateurs, l’IA quitte la sphère du rêve pour devenir un projet scientifique. Les premiers programmes démontrent des théorèmes mathématiques ou jouent aux échecs à un niveau rudimentaire.

Alan Turing, en 1936 (Université Princeton)

Les années d’or de l’IA symbolique

Les années 1960-1970 sont celles des pionniers enthousiastes. On programme des machines capables de résoudre des problèmes logiques, de jouer aux échecs ou même de simuler un psychothérapeute (ELIZA). L’ambition est claire : reproduire le raisonnement humain par un enchaînement de règles codées.

Mais très vite, la réalité se venge : ces systèmes brillent dans des univers simples… et s’effondrent dès que le monde réel, complexe et ambigu, s’invite dans la partie.

Les hivers de l’IA

L’optimisme débridé des débuts laisse place au scepticisme. On sait ce qu’on aimerait faire, mais la technologie ne suit pas. Les ordinateurs sont trop lents, les données trop rares. En d’autres termes, les limites viennent du manque de puissance de calcul et de l’insuffisance des bases de données.

Commence alors une période de « glaciation » pour l’intelligence artificielle : budgets coupés, laboratoires fermés, chercheurs reconvertis. Il faudra attendre les années 1990 pour voir le dégel.

La renaissance par l’apprentissage

Plutôt que de tout programmer, les chercheurs changent de méthode : :au lieu de tout programmer, on conçoit la machine avec des algorithmes d’apprentissage automatique à partir de d’exemples et de données. C’est l’avènement du machine learning. L’arrivée des réseaux de neurones artificiels, inspirés du cerveau humain, se traduit par une puissance de calcul en forte hausse. La machine décuple son efficacité. Elle ne raisonne plus seulement avec des règles figées : elle détecte des motifs, reconnaît des visages, comprend la parole. L’IA excelle désormais dans des tâches spécifiques : reconnaissance vocale, détection d’images, traduction automatique.

Illustration d'un réseau de neurones artificiels et d'une puce (chip)

(mikemacmarketing / flickr, CC BY 2.0 )

Le big bang de l’IA profonde

En 2012, une révolution éclate : l’apprentissage profond (deep learning). La mise à disposition de réseaux de neurones à dizaines de couches, entraînés sur des milliards de données, propulse l’IA dans une nouvelle dimension. En 2016, AlphaGo bat le champion du monde de go, un jeu réputé imprenable pour les ordinateurs. Les modèles de langage (GPT, BERT) écrivent des textes bluffants, tandis que les générateurs d’images (DALL·E, Midjourney) transforment une phrase en œuvre graphique.

L’IA sort des laboratoires : elle transforme de nombreux secteurs — (santé, finance, art, éducation, etc.) et, pour le grand public, elle entre dans les téléphones, les voitures, les appications de création, etc.

Et demain ?

L’histoire de l’IA est un récit en dents de scie, fait d’euphorie et de scepticisme. Aujourd’hui, nous sommes à un moment charnière : l’IA générative, capable de produire textes, images, vidéos ou codes, n’est qu’une étape vers des systèmes plus polyvalents et adaptatifs.

Certains chercheurs visent désormais l’IA générale (Artificial General Intelligence, ou AGI) — une intelligence artificielle capable d’apprendre et de raisonner dans n’importe quel domaine, comme un humain. Les avis divergent : pour les optimistes, cela pourrait survenir en quelques décennies ; pour les prudents, il reste des obstacles majeurs, notamment la compréhension du bon sens humain, la gestion des contextes complexes et l’intégration d’émotions ou de motivations.

Une autre piste se dessine : les IA collectives, où plusieurs systèmes interconnectés coopèrent pour résoudre des problèmes à l’échelle mondiale : planification climatique, gestion de crises, exploration spatiale. Mais cette puissance soulève des questions éthiques cruciales : qui contrôle ces systèmes ? Comment éviter les biais, la désinformation ou la dépendance excessive ?

En parallèle, l’IA pourrait aussi se banaliser au point de devenir invisible — comme l’électricité aujourd’hui. Elle serait partout, intégrée dans chaque outil, mais ne serait plus perçue comme une « entité » distincte.

Conclusion : l’IA comme prolongement de l’humain ?

Depuis ses racines mythologiques jusqu’à ses prouesses d’aujourd’hui, l’intelligence artificielle n’a cessé d’élargir notre horizon. Chaque étape a suscité les mêmes interrogations : Est-ce la fin d’un savoir-faire ? Allons-nous perdre notre place ? Et pourtant, l’histoire prouve que chaque révolution technique déplace la frontière entre l’homme et la machine sans effacer la créativité, l’intuition et l’émotion humaines.

Le moteur n’a pas tué le muscle, il l’a démultiplié. L’imprimerie n’a pas remplacé la mémoire, elle l’a élargie.

L’IA pourrait devenir notre nouvel amplificateur, libérant du temps et de l’énergie pour inventer, rêver, explorer. La vraie question n’est pas ce qu’elle fera à notre place, mais ce que nous ferons avec ce supplément de puissance. L’avenir n’est pas écrit… et c’est précisément là que notre intelligence – naturelle, celle-là – a encore tout son rôle à jouer.

L’avenir de l’IA dépendra moins de ses performances techniques que de la façon dont nous l’intégrerons à nos choix collectifs. Entre outil d’émancipation et instrument de contrôle, entre accélérateur d’innovation et menace pour certaines valeurs, c’est à nous — et non à la machine — de tracer la voie.

L’IA n’éteint pas la flamme créative, elle l’attise

Sven Rasmussen

L’intelligence artificielle ne tue pas la créativité — elle l’amplifie

Quand les premières machines à vapeur ont remplacé les chevaux dans les usines, les mines ou les transports, un discours alarmiste a dominé : « Le moteur va tuer le muscle humain ». Pourtant, le moteur n’a pas rendu l’homme inutile — il a démultiplié sa puissance. Il a permis de creuser plus profond, de bâtir plus haut, de voyager plus loin. Aujourd’hui, le même scénario se rejoue avec l’intelligence artificielle : on craint qu’elle ne remplace notre créativité, alors qu’elle pourrait bien l’amplifier.

La créativité n'a pas de limite

L’idée que l’IA « prendrait » une part de créativité comme on prendrait une part de gâteau repose sur un malentendu. La créativité n’est pas un stock fini, c’est une capacité de combiner, détourner, réinterpréter. Les outils numériques — traitement de texte, logiciels de montage, photographie numérique — ont déjà permis à des millions de personnes de s’exprimer qui ne l’auraient jamais fait avec un pinceau ou une caméra argentique. L’IA suit la même logique : elle réduit les obstacles techniques pour passer plus vite de l’idée au prototype

Du moteur mécanique au moteur cognitif

L’IA joue aujourd’hui le rôle que le moteur à combustion a joué hier : un multiplicateur de puissance. Là où le moteur amplifiait la force musculaire, l’IA amplifie la force intellectuelle. Elle automatise certaines tâches répétitives — recherche documentaire, mise en page, structuration de données — pour libérer du temps et de l’énergie mentale, que l’humain peut réinvestir dans l’imagination, l’expérimentation et l’invention.

Des collaborations inédites

L’histoire montre que chaque nouvelle technologie créative — de l’imprimerie à la photographie — n’a pas effacé les artistes, mais a créé de nouvelles formes d’art. L’IA ouvre des terrains inédits :

- Musique générative qui permet à des compositeurs d’explorer des harmonies impossibles à imaginer seul.

- Images synthétiques qui servent d’esquisses pour sculpter un univers visuel.

- Narrations interactives où le lecteur devient co-auteur grâce à des dialogues avec une IA.

La créativité humaine ne disparaît pas : elle se déplace, se redéfinit et se nourrit de cette interaction.

Le vrai danger : la paresse créative

L’IA ne tue pas la créativité, mais elle peut l’endormir si on se contente de prendre ce qu’elle produit sans y injecter sa vision. Comme le moteur n’a pas supprimé l’effort physique — il l’a déplacé vers la maîtrise et l’entretien de la machine — l’IA demande de nouvelles compétences : savoir formuler des questions précises, affiner un style, critiquer et retravailler les propositions.

Vers un âge d’or de la créativité amplifiée

Dans les décennies à venir, il est probable que l’IA devienne un partenaire de création aussi banal que l’est aujourd’hui un logiciel de retouche photo. Elle ne remplacera pas l’étincelle humaine — ce mélange d’expérience vécue, d’émotion et de curiosité qui échappe aux algorithmes — mais elle élargira la palette de ce que nous pouvons imaginer et réaliser.

Conclusion

L’intelligence artificielle n’est pas la fin de la créativité, mais une étape dans son évolution. Comme le moteur a transformé la force musculaire en puissance industrielle, l’IA transforme notre capacité intellectuelle en puissance créative. La question n’est pas de savoir si elle va nous remplacer, mais si nous saurons l’apprivoiser pour inventer ensemble de nouvelles manières de rêver, raconter et construire.

L’intelligence artificielle reste un outil : c’est la créativité humaine qui décide jusqu’où elle ira.

Neurone artificiel

Un neurone artificiel est une petite brique mathématique, inspirée (de loin) du fonctionnement d’un neurone biologique.

Dans notre cerveau, un neurone reçoit des signaux électriques venant d’autres neurones, les combine, et s’il est assez stimulé, il transmet à son tour un signal.

En intelligence artificielle, on a transposé cette idée sous forme très simplifiée :

-

le neurone artificiel reçoit plusieurs entrées (par exemple les pixels d’une image, ou les mots d’une phrase),

-

il pondère chacune de ces entrées (grâce à des coefficients qu’on appelle poids),

-

il fait une somme de ces signaux,

-

puis il applique une fonction d’activation (par exemple décider si le résultat est « assez fort » pour envoyer une sortie).

Un neurone artificiel seul ne fait pas grand-chose. Mais en les reliant par milliers, millions, voire milliards dans ce qu’on appelle des réseaux de neurones artificiels, on obtient des systèmes capables de reconnaître un visage, traduire une langue ou générer une image.

En résumé, le neurone biologique traite des signaux électriques et chimiques, le neurone artificiel traite des nombres, par des calculs simples. Ce n’est pas une copie fidèle du cerveau, mais une analogie qui s’avère surtout pertinente dès qu’on met beaucoup de neurones artificiels ensemble pour en faire des réseaux en couches.

Peur que l’IA remplace ta créativité ?

C’est comme refuser un vélo parce que tu sais marcher. L’IA ne remplace pas ton talent : elle l’emmène plus loin. Avec ou sans toi.